进入令人着迷的神经 *** 世界,探索从简单的感知器到复杂深度学习模型的迷人历程。在这个数字时代,神经 *** 已成为人工智能和机器学习领域的基石,让我们揭开它们设计的秘密,踏上人工智能的前沿。

感知器:神经 *** 的雏形

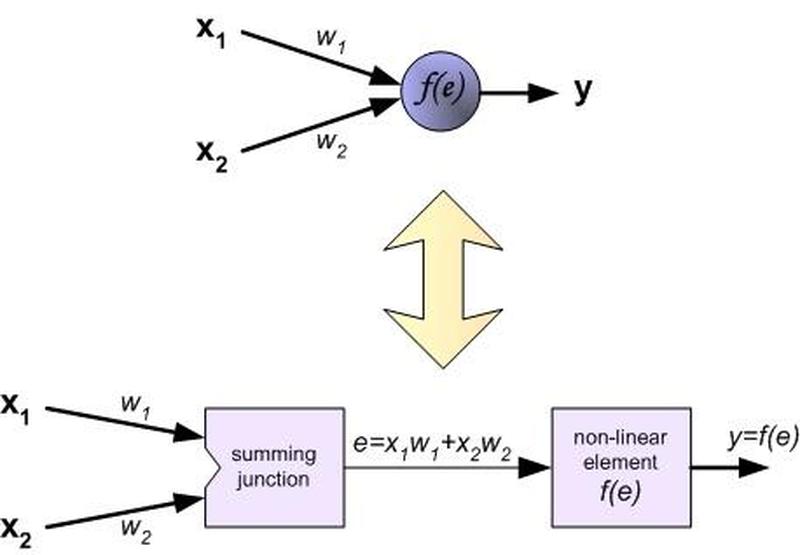

感知器是神经 *** 的鼻祖,它是一个简单的模型,可将输入数据分类为两类。感知器的工作原理类似于人脑中的神经元,它接收输入,对其加权并输出一个二进制值(0 或 1)。

神经元:大脑的基石

神经 *** 中的神经元类似于大脑中的神经元,它们接收输入信号、处理它们并产生输出。神经元由以下部分组成:

- 突触:接收来自其他神经元的信号。

- 细胞体:对输入信号求和。

- 轴突:将输出信号传递给其他神经元。

权重:调节输入信号的影响

权重是与神经元的突触相关的数字值,它们控制输入信号对神经元输出的影响。权重可以是正值或负值,正值表示激发性影响,而负值表示抑制性影响。

阈值:触发输出的临界点

阈值是一个界限,神经元的输入必须超过它才能产生输出。如果输入的总和超过阈值,则神经元将被激活并产生输出;否则,神经元将保持非激活状态。

多层感知器:感知器的扩展

多层感知器(MLP)是对感知器的扩展,它具有多个隐藏层,允许模型学习复杂模式和非线性关系。隐藏层是由神经元组成的,它们接收来自输入层或前一层隐藏层的输入,并对其进行处理。

浅层 *** 与深层 ***

MLP可以分为浅层 *** 和深层 *** 。浅层 *** 只有几个隐藏层,而深层 *** 可能有多达数百或数千个隐藏层。深层 *** 能够学习更复杂的关系,但它们也更难训练。

激活函数:引入非线性

激活函数是非线性函数,它们被应用于神经元的输出以引入非线性。非线性允许 *** 学习复杂模式,而线性函数则无法做到这一点。常见的激活函数包括 sigmoid、tanh 和 ReLU。

卷积神经 *** :处理图像的专家

卷积神经 *** (CNN)是专门用于处理图像数据的 *** 。它们使用卷积层,该层使用滤波器在图像中滑动并提取特征。CNN 已被广泛应用于图像分类、目标检测和语义分割等任务。

卷积层:特征提取的引擎

卷积层使用滤波器在图像中滑动,提取图像中的特征。滤波器是一组权重,它们应用于输入图像的局部区域。卷积操作生成一个特征图,其中每个元素表示一个特定特征的强度。

池化层:降维和增强鲁棒性

池化层是对卷积层输出的降采样操作。它们通过将相邻元素组合成一个元素来减小特征图的大小。池化有助于减少计算量并提高 *** 的鲁棒性。

深度学习:神经 *** 的巅峰之作

深度学习指的是具有许多隐藏层的神经 *** 。深度学习模型能够学习高度复杂的关系,并已在图像分类、自然语言处理和强化学习等广泛的任务中取得了惊人的突破。

Dropout:防止过拟合的救星

Dropout是一种正则化技术,它通过在训练期间随机丢弃一些神经元来防止神经 *** 过拟合。丢弃有助于减少 *** 对训练数据的依赖,并提高其泛化能力。

批处理归一化:稳定训练过程

批处理归一化是一种技术,用于将每个小批量的 *** 输入标准化。这有助于稳定训练过程并提高 *** 的收敛速度。批处理归一化对于训练深度神经 *** 至关重要。

结语

神经 *** 设计从简单的感知器一路发展到复杂的深度学习模型,见证了人工智能领域的飞速发展。了解神经 *** 的关键要素,从感知器到深度学习,将使您能够驾驭人工智能的无限潜力,并为未来的创新做出贡献。